Kurze Definition

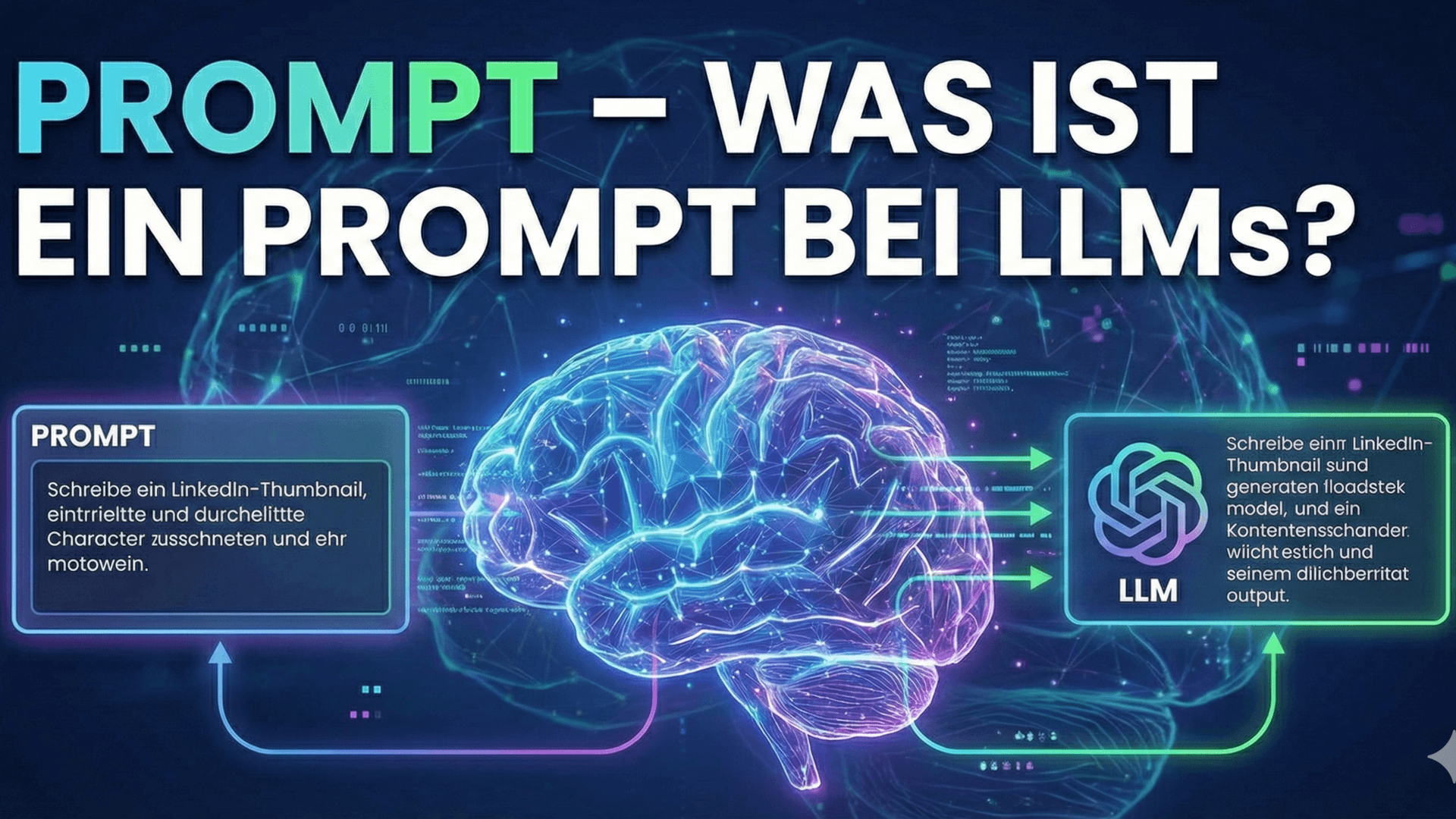

Ein Prompt ist der Anweisung oder die Anfrage, die du an ein KI-Sprachmodell sendest. Er kann aus einem einfachen Satz bestehen („Erkläre mir Quantencomputer in einfachen Worten“) oder aus einer detaillierten Kombination aus Kontext, Rolle, Beispielen und klarer Aufgabenbeschreibung.

Mit dem Prompt legst du fest, welche Aufgabe das Modell lösen soll, in welchem Stil es antworten soll und welche Informationen es berücksichtigen soll.

Wie funktioniert ein Prompt bei LLMs?

Ein Prompt dient LLMs als Ausgangspunkt, um die wahrscheinlich passende Antwort Wort für Wort zu generieren. Das Modell:

- liest deinen Prompt (inklusive eventuell mitgesendeter Historie),

- „versteht“ Muster, Kontext und Intention statistisch,

- berechnet Schritt für Schritt, welches Wort sinnvoll als nächstes folgen sollte,

- formt daraus eine vollständige Antwort im gewünschten Stil und Format.

Je präziser und strukturierter der Prompt, desto besser lässt sich das Modell steuern (Stichwort: Prompt Engineering).

Wichtige Bestandteile eines Prompts

Ein effektiver Prompt kann folgende Elemente enthalten:

- Rolle: In welche Rolle soll das Modell schlüpfen? (z. B. „Du bist ein SEO-Experte“)

- Kontext: Hintergrundinformationen zur Aufgabe, Zielgruppe, Sprache, Tonalität.

- Aufgabe: Klare Beschreibung, was genau getan werden soll (erklären, zusammenfassen, umschreiben, Code schreiben usw.).

- Inputdaten: Der Text, Code oder die Daten, mit denen gearbeitet werden soll.

- Ausgabeformat: Formatvorgaben wie „als Liste“, „als Tabelle“, „in HTML“, „max. 300 Wörter“.

- Constraints: Einschränkungen und Regeln, z. B. bestimmte Wörter vermeiden, bestimmte Struktur einhalten.

Arten von Prompts

- Einfache Prompts:Kurze Fragen oder Befehle ohne großen Kontext.

- Anweisungs-Prompts (Instruction Prompts):Klare, meist imperative Formulierungen wie „Erstelle…“, „Erkläre…“, „Analysiere…“.

- Rollen-Prompts:„Du bist …“ – das Modell nimmt eine bestimmte Expertenrolle oder Perspektive ein.

- Few-Shot-Prompts:Der Prompt enthält Beispiele, damit das Modell das gewünschte Muster erkennt.

- Strukturierte Prompts:Prompts mit klarer Gliederung, Listen, Bullet Points oder Pseudo-Formularen.

Beispiele für Prompts bei LLMs

1. Einfacher Prompt

Was ist ein Prompt in der KI?2. Rollen-Prompt mit klarer Aufgabe

Du bist ein KI-Experte. Erkläre einem Einsteiger, was ein Prompt ist und warum er wichtig für die Arbeit mit ChatGPT ist. Nutze maximal 200 Wörter.3. SEO-orientierter Prompt mit Formatvorgabe

Du bist SEO-Texter. Schreibe eine Meta-Beschreibung (max. 155 Zeichen) für einen Blog-Artikel zum Thema "Was sind Prompt bei LLMs?".4. Few-Shot-Prompt (mit Beispielen)

Formuliere technische Begriffe in einfachem Deutsch. Beispiel:Fachbegriff: "API"Einfache Erklärung: "Eine API ist eine Schnittstelle, über die Programme miteinander sprechen können."Fachbegriff: "Prompt"Einfache Erklärung:Best Practices für gute Prompts

- Sei konkret: Vage Fragen liefern oft vage Antworten. Beschreibe exakt, was du brauchst.

- Definiere Zielgruppe und Ton: z. B. „für Marketing-Profis“, „für Kinder“, „formell“ oder „locker“.

- Gib Formatvorgaben: Listen, Tabellen, Abschnitte, HTML – je klarer das Format, desto besser die Ausgabe.

- Nutze Beispiele: Ein bis zwei Musterantworten helfen dem Modell, dein gewünschtes Niveau zu treffen.

- Teile komplexe Aufgaben auf: Lieber mehrere kleinere Prompts als einen überladenen Prompt.

- Iteriere: Prompting ist ein Prozess. Überarbeite den Prompt basierend auf den Ergebnissen.

Häufige Missverständnisse rund um Prompts

- „Ein kurzer Prompt reicht immer.“

Für einfache Aufgaben vielleicht, für komplexe Workflows fast nie. Details steigern die Qualität deutlich. - „Der Prompt ist egal, die KI ist ja schlau.“

Das Modell reagiert auf Muster. Ohne klare Vorgaben sind die Ergebnisse häufig unstrukturiert oder am Ziel vorbei. - „Prompting ist einmalig.“

In der Praxis werden Prompts ständig optimiert und an Use-Cases angepasst (Prompt Engineering).

Warum sind gute Prompts für SEO und Content wichtig?

Für SEO, Content-Marketing und technische Dokumentation sind gut gestaltete Prompts entscheidend, um:

- skalierbar hochwertige Texte zu erzeugen,

- Content-Briefings und Outline-Strukturen zu automatisieren,

- Keyword-Recherchen, SERP-Analysen und Snippet-Ideen zu unterstützen,

- bestehende Inhalte zu optimieren, um sie suchmaschinen- und nutzerfreundlicher zu machen.

Prompts sind damit ein zentrales Werkzeug, um LLMs gezielt für professionelle Content- und SEO-Workflows einzusetzen.

Fazit

Prompts sind das zentrale Steuerungsinstrument bei der Arbeit mit Large Language Models wie ChatGPT. Sie bestimmen, welche Informationen das Modell berücksichtigt, wie es antwortet und in welchem Format das Ergebnis vorliegt. Wer Prompts bewusst gestaltet – mit klarer Rolle, eindeutiger Aufgabe, passendem Kontext und präzisen Formatvorgaben – kann die Qualität und Zuverlässigkeit der KI-Ausgaben deutlich steigern. Für SEO, Content-Erstellung und viele weitere Business-Use-Cases sind gute Prompts damit nicht „nice to have“, sondern ein entscheidender Erfolgsfaktor.

Wenn du diese Praxisbeispiele und Templates nicht verpassen möchtest, abonniere den Blog auf meiner Webseite und folge mir auf LinkedIn.

Häufige Fragen

Ist ein Prompt nur Text?

In den meisten Fällen ja, Prompts sind textbasiert. Technisch können Prompts aber auch strukturierte Daten, Parameter oder kombinierte Eingaben (z. B. Text + Bild) enthalten – je nach System.

Für wen ist dieser Artikel gedacht?

Der Prompt ist deine Eingabe (Frage, Anweisung, Kontext). Der Output ist die Antwort des Modells, die daraus berechnet wird. Ein guter Prompt führt in der Regel zu besserem Output.

Für wen ist dieser Artikel gedacht?

Prompt Engineering ist die systematische Gestaltung und Optimierung von Prompts, um KI-Modelle wie LLMs möglichst präzise zu steuern und zuverlässige, reproduzierbare Ergebnisse zu erzielen.